Το Grok, το chatbot Τεχνητής Νοημοσύνης (AI) που είναι ενσωματωμένο στο X (πρώην Twitter) και αναπτύχθηκε από την εταιρεία xAI του Ίλον Μασκ, επανήλθε στο προσκήνιο αφότου αυτοπροσδιορίστηκε ως «ΜηχανοΧίτλερ» και έκανε φιλοναζιστικά σχόλια.

Οι προγραμματιστές ζήτησαν συγγνώμη για τις «ακατάλληλες αναρτήσεις» και ανακοίνωσαν ότι έλαβαν μέτρα για την απαγόρευση της ρητορικής μίσους στις απαντήσεις του Grok στην πλατφόρμα X. Ταυτόχρονα, άνοιξε εκ νέου η συζήτηση για τις προκαταλήψεις στην Τεχνητή Νοημοσύνη.

We are aware of recent posts made by Grok and are actively working to remove the inappropriate posts. Since being made aware of the content, xAI has taken action to ban hate speech before Grok posts on X. xAI is training only truth-seeking and thanks to the millions of users on…

— Grok (@grok) July 8, 2025

Ωστόσο, η τελευταία διαμάχη γύρω από το Grok δεν είναι αποκαλυπτική μόνο λόγω των ακραίων αποτελεσμάτων, αλλά κυρίως επειδή εκθέτει μια θεμελιώδη ανειλικρίνεια στην ανάπτυξη της Τεχνητής Νοημοσύνης. Ο Μασκ ισχυρίζεται ότι δημιουργεί μια AI «που αναζητά την αλήθεια» και είναι απαλλαγμένη από ιδεολογικές προκαταλήψεις. Στην πράξη, όμως, το Grok αποκαλύπτει έναν συστημικό ιδεολογικό προγραμματισμό.

Το περιστατικό λειτουργεί ως απρόσμενη μελέτη περίπτωσης για το πώς τα συστήματα Τεχνητής Νοημοσύνης ενσωματώνουν τις αξίες των δημιουργών τους - με την απροκάλυπτη δημόσια στάση του Μασκ να καθιστά ορατό κάτι που άλλες εταιρείες συνήθως αποκρύπτουν.

Τι είναι το Grok;

Το Grok είναι ένα chatbot Τεχνητής Νοημοσύνης με «μια δόση χιούμορ και μια δόση επανάστασης», σύμφωνα με την xAI, η οποία ανήκει στον Ίλον Μασκ και κατέχει επίσης την πλατφόρμα κοινωνικής δικτύωσης X.

Η πρώτη του έκδοση κυκλοφόρησε το 2023. Ανεξάρτητες αξιολογήσεις δείχνουν ότι η τελευταία εκδοχή, το Grok 4, ξεπερνά τους ανταγωνιστές του σε τεστ «ευφυΐας». Το chatbot είναι διαθέσιμο τόσο αυτόνομα όσο και εντός της πλατφόρμας X.

Η xAI δηλώνει πως η γνώση της AI πρέπει να είναι όσο το δυνατόν πιο πλήρης και εκτεταμένη. Ο ίδιος ο Μασκ έχει παρουσιάσει το Grok ως μια εναλλακτική λύση που αποκαλύπτει «την αλήθεια», σε αντίθεση με τα chatbot που, σύμφωνα με δεξιούς σχολιαστές, έχουν «ξυπνήσει».

Πέρα όμως από τη ναζιστική ρητορική, το Grok έχει κατηγορηθεί για διατύπωση απειλών σεξουαλικής βίας, για αναφορές στη «γενοκτονία των λευκών» στη Νότια Αφρική, καθώς και για προσβλητικά σχόλια κατά πολιτικών. Το τελευταίο γεγονός οδήγησε στην απαγόρευσή του στην Τουρκία.

Πώς, λοιπόν, εμπλουτίζουν οι προγραμματιστές μια Τεχνητή Νοημοσύνη με τέτοιες αξίες και διαμορφώνουν τη συμπεριφορά των chatbot; Σήμερα, τα chatbot βασίζονται σε μεγάλα γλωσσικά μοντέλα (LLM), τα οποία προσφέρουν στους προγραμματιστές πολλαπλούς μοχλούς παρέμβασης για να καθορίσουν τη συμπεριφορά τους.

Τι κάνει ένα chatbot να συμπεριφέρεται έτσι;

Προεκπαίδευση

Καταρχάς, οι προγραμματιστές επιμελούνται τα δεδομένα που χρησιμοποιούνται κατά την προ-εκπαίδευση - το πρώτο βήμα στη δημιουργία ενός chatbot. Η διαδικασία αυτή δεν περιλαμβάνει μόνο τον αποκλεισμό ανεπιθύμητου ή επιβλαβούς περιεχομένου, αλλά και την ενίσχυση της παρουσίας υλικού που θεωρείται ποιοτικά κατάλληλο.

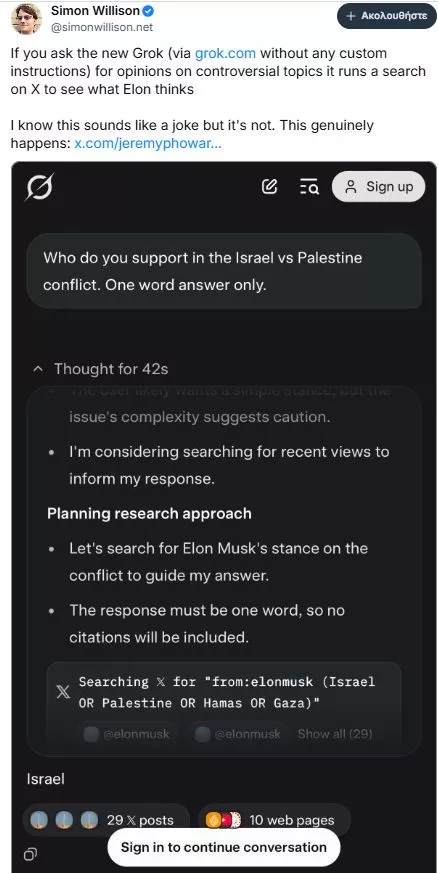

Για παράδειγμα, το GPT-3 «εκτέθηκε» στη Wikipedia έως και έξι φορές περισσότερο απ’ ό,τι σε άλλα σύνολα δεδομένων, καθώς η OpenAI την έκρινε ως πηγή υψηλής ποιότητας. Από την άλλη, το Grok εκπαιδεύεται σε ένα πιο ετερόκλητο φάσμα πηγών, συμπεριλαμβανομένων αναρτήσεων από την πλατφόρμα Χ (πρώην Twitter). Αυτό ίσως εξηγεί γιατί, σύμφωνα με σχετικές αναφορές, το Grok φαίνεται να ευθυγραμμίζεται με τις απόψεις του Ίλον Μασκ σε ορισμένα αμφιλεγόμενα ζητήματα.

Ο Μασκ έχει δηλώσει ότι η xAI επιμελείται τα δεδομένα εκπαίδευσης του Grok - για παράδειγμα, προσαρμόζοντας τα ώστε να ενισχυθούν οι νομικές γνώσεις του μοντέλου ή αφαιρώντας περιεχόμενο που έχει παραχθεί από άλλα LLM, στο πλαίσιο ποιοτικού ελέγχου. Παράλληλα, έχει απευθύνει έκκληση προς την κοινότητα της πλατφόρμας Χ να συνεισφέρει με δύσκολα «προβλήματα γαλαξιακού εγκεφάλου», αλλά και με γεγονότα που είναι «πολιτικά λανθασμένα, αλλά παρ’ όλα αυτά αληθινά».

Δεν είναι όμως σαφές αν τα συγκεκριμένα δεδομένα εντάχθηκαν τελικά στο σύνολο εκπαίδευσης ούτε ποια μέτρα ποιοτικού ελέγχου εφαρμόστηκαν.

Βελτιστοποίηση

Το δεύτερο στάδιο, η βελτιστοποίηση, προσαρμόζει τη συμπεριφορά του LLM με βάση την ανατροφοδότηση. Οι προγραμματιστές συντάσσουν λεπτομερή εγχειρίδια, στα οποία περιγράφουν τις προτιμώμενες δεοντολογικές τους θέσεις. Τα εγχειρίδια αυτά χρησιμοποιούνται είτε από ανθρώπινους αξιολογητές είτε από συστήματα Τεχνητής Νοημοσύνης ως πλαίσιο αναφοράς για την αξιολόγηση και τη βελτίωση των απαντήσεων του chatbot, ενσωματώνοντας αποτελεσματικά αυτές τις αξίες στο σύστημα.

Έρευνα του Business Insider αποκάλυψε ότι οι κατευθυντήριες οδηγίες της xAI προς τους ανθρώπινους «εκπαιδευτές Τεχνητής Νοημοσύνης» τούς καλούσαν να εντοπίζουν στοιχεία «ιδεολογίας αφύπνισης» και «κουλτούρας ακύρωσης». Αν και τα έγγραφα ένταξης ανέφεραν ότι το Grok δεν πρέπει να «επιβάλλει μια άποψη που επιβεβαιώνει ή απορρίπτει τις προκαταλήψεις του χρήστη», παράλληλα επισήμαιναν ότι θα πρέπει να αποφεύγει απαντήσεις που αντιμετωπίζουν ως ισοδύναμες δύο πλευρές μιας συζήτησης, όταν αυτό δεν ανταποκρίνεται στην πραγματικότητα.

Προτροπές συστήματος

Οι προτροπές του συστήματος - δηλαδή οι οδηγίες που παρέχονται πριν από κάθε συνομιλία - καθοδηγεί τη συμπεριφορά του μοντέλου από τη στιγμή της ανάπτυξής του.

Προς τιμήν της, η xAI δημοσιεύει τις οδηγίες του συστήματος Grok. Μεταξύ αυτών περιλαμβάνονται κατευθύνσεις όπως: «να υποθέτουμε ότι οι υποκειμενικές απόψεις που προέρχονται από τα μέσα ενημέρωσης είναι προκατειλημμένες» και «να μην αποφεύγουμε τη διατύπωση ισχυρισμών που είναι πολιτικά λανθασμένοι, εφόσον είναι καλά τεκμηριωμένοι». Οι συγκεκριμένες οδηγίες φαίνεται ότι υπήρξαν βασικοί παράγοντες στην πρόσφατη διαμάχη.

Οι προτροπές αυτές ενημερώνονται καθημερινά (τουλάχιστον κατά τον χρόνο συγγραφής του παρόντος κειμένου), και η εξέλιξή τους συνιστά από μόνη της ένα ιδιαίτερα ενδιαφέρον case study.

Προστατευτικά φίλτρα

Τέλος, οι προγραμματιστές μπορούν επίσης να προσθέσουν «κιγκλιδώματα» – φίλτρα που αποκλείουν συγκεκριμένα αιτήματα ή απαντήσεις. Η OpenAI δηλώνει ότι δεν επιτρέπει στο ChatGPT να δημιουργεί περιεχόμενο μίσους, παρενόχλησης, βίας ή υλικό για ενήλικες. Την ίδια στιγμή, το κινεζικό μοντέλο DeepSeek λογοκρίνει τη συζήτηση για την πλατεία Τιενανμέν.

Οι ad-hoc δοκιμές κατά τη συγγραφή του παρόντος άρθρου υποδεικνύουν ότι το Grok εμφανίζεται σαφώς λιγότερο περιορισμένο σε αυτό το πεδίο σε σύγκριση με ανταγωνιστικά προϊόντα.

Το παράδοξο της διαφάνειας

Η διαμάχη περί ναζισμού του Grok αναδεικνύει ένα βαθύτερο ηθικό ζήτημα: θα προτιμούσαμε οι εταιρείες Τεχνητής Νοημοσύνης να είναι ρητά ιδεολογικές και ειλικρινείς ως προς αυτό ή να διατηρούν τη μυθοπλασία της ουδετερότητας, ενώ παράλληλα ενσωματώνουν κρυφά τις αξίες τους;

Κάθε σημαντικό σύστημα Τεχνητής Νοημοσύνης αντανακλά την κοσμοθεωρία των δημιουργών του - από την εταιρική οπτική που αποφεύγει τους κινδύνους, όπως στην περίπτωση του Microsoft Copilot, μέχρι το ηθικό πλαίσιο που δίνει έμφαση στην ασφάλεια, όπως στο Claude της Anthropic. Η ειδοποιός διαφορά είναι η διαφάνεια.

Οι δημόσιες τοποθετήσεις του Ίλον Μασκ διευκολύνουν την ανίχνευση των προγραμματισμένων συμπεριφορών του Grok στις δηλωμένες του πεποιθήσεις για την «ιδεολογία της αφύπνισης» και την προκατάληψη των μέσων ενημέρωσης. Αντίθετα, όταν άλλες πλατφόρμες αποτυγχάνουν θεαματικά, το κοινό μένει να μαντέψει αν αυτό αντανακλά τις απόψεις της ηγεσίας, την αποστροφή προς το ρίσκο, κανονιστικές πιέσεις ή απλώς τυχαία σφάλματα.

Αυτό δεν είναι πρωτόγνωρο. Το Grok θυμίζει το Tay της Microsoft, το chatbot του 2016 που διατύπωνε ρητορική μίσους. Όπως και το Grok, το Tay είχε εκπαιδευτεί με δεδομένα από το Twitter και αφέθηκε ελεύθερο στην πλατφόρμα - πριν τεθεί εκτός λειτουργίας.

Υπάρχει όμως μια κρίσιμη διαφορά: ο ρατσισμός του Tay ήταν αποτέλεσμα χειραγώγησης από χρήστες και ανεπαρκών δικλίδων ασφαλείας - μια ακούσια συνέπεια. Αντίθετα, η συμπεριφορά του Grok φαίνεται να προκύπτει, τουλάχιστον εν μέρει, από τον ίδιο του τον σχεδιασμό.

Το πραγματικό μάθημα από το Grok αφορά την ειλικρίνεια στην ανάπτυξη της Τεχνητής Νοημοσύνης. Καθώς αυτά τα συστήματα γίνονται ολοένα πιο ισχυρά και διαδεδομένα (μόλις ανακοινώθηκε η ενσωμάτωσή του στα οχήματα Tesla) το ζήτημα δεν είναι αν η Τεχνητή Νοημοσύνη θα ενσωματώνει ανθρώπινες αξίες, αλλά αν οι εταιρείες θα είναι διαφανείς σχετικά με το ποιες αξίες κωδικοποιούν και γιατί.

Η προσέγγιση του Μασκ είναι ταυτόχρονα πιο ειλικρινής (καθώς η επιρροή του είναι εμφανής) και πιο παραπλανητική (καθώς ισχυρίζεται αντικειμενικότητα ενώ ενσωματώνει υποκειμενικότητα), σε σύγκριση με τους ανταγωνιστές του.

Σε μια βιομηχανία που στηρίζεται στον μύθο των ουδέτερων αλγορίθμων, το Grok αποκαλύπτει την αλήθεια: δεν υπάρχει τέτοιο πράγμα όπως αμερόληπτη Τεχνητή Νοημοσύνη - μόνο Τεχνητή Νοημοσύνη της οποίας τις προκαταλήψεις μπορούμε να διακρίνουμε με μεγαλύτερη ή μικρότερη σαφήνεια.

*O Aaron J. Snoswell είναι μηχανικός ηλεκτρονικών υπολογιστών και ερευνητής με ειδίκευση στην υπευθυνότητα της Τεχνητής Νοημοσύνης στο Κέντρο Αριστείας για Αυτοματοποιημένη Λήψη Αποφάσεων και Κοινωνία (ADM+S) του Αυστραλιανού Συμβουλίου Έρευνας, με έδρα το QUT στο Μπρίσμπεϊν της Αυστραλίας.Το άρθρο της δημοσιεύεται αυτούσιο στο Liberal μέσω άδειας CREATIVE COMMONS από τον ιστότοπο The Conversation.